Pixel独眼吊打双摄?谷歌其实藏着个5摄怪兽

人气:0手机圈里,一向不按套路出牌的莫过于谷歌的Pixel系列。除了颜值剑走偏锋(越走越歪)以外,Pixel的拍照系统更是自成一派,虽三代“单传”(单摄),却仍吊打了不少同辈的拍照好手。

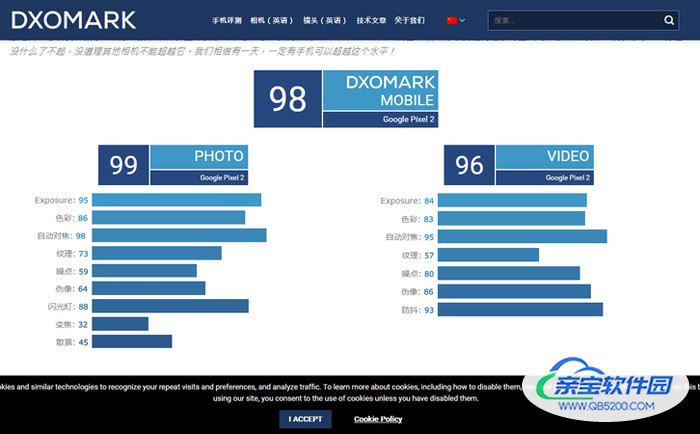

从去年开始,手机厂商多以DxOmark的评分一决手机拍照高下。你可知道,在去年10月份发布的Pixel2,目前仍跻身排行榜总榜第十?对比起同年发布的那些双摄手机,纵有“东方明珠”、“未来十年”之称,也没敌过这个独眼怪。Pixel2拍照实力已是如此,Pixel3如何自然不言而喻。

硬件不够,算法来凑

Pixel系列拍照的过人之处,主要在夜景拍摄和人像拍摄两大方面。尤其是在极度暗光的环境下,普通双摄手机成像已经是黑漆漆一片,而最新的Pixel3在拍得见的同时,还能留住不少的画面细节。不禁想起药王庙那晚,令狐冲只一招独孤九剑,直教八个贼人十六双眼尽瞎…

至于人像拍摄方面,Pixel系列的背景虚化能力也是较为了得的。我们知道,一些双摄手机在拍摄人像时,总不免出现景深虚化不到位的情况,明明是人的五指却无端被虚化掉,远处本该发虚的树木却枝叶可辨。虽然Pixel3也存在这样的情况,但出现的几率较少,何况人家还只是单摄。

其实无论是夜景拍摄还是人像拍摄,之所以Pixel拍照能够“一vs多”,除了用上了业界口碑不错的摄像头模组,更重要的是其背后极强的算法能力。在夜景环境下,无论是单摄还是多摄,其工作原理都基本相同:开启HDR,利用多帧合成的方式成像。取多少帧、每一帧的参数如何设置、多帧拍摄之后如何合成优化,全靠背后的算法。这就是为什么大家用同一个摄像头,成像却有好有差。

时下,人像拍摄以双摄最为流行,之所以流行,一是逼不得已,二是相对简单。即使现在手机最大光圈达到f/1.3, 但受制于手机传感器尺寸大小,能够记录的光学信息有限,实际出来的效果并不明显,更别说媲美同光圈大小的相机镜头,所以就目前来说在手机上采用大光圈来实现背景虚化并不现实,除非传感器尺寸大小能够进一步突破。而这还仅仅只是其中一个前提。(By Uncle Zhang)

所以,手机拍摄要想获得较好的背景虚化效果只能从焦距下功夫。比较常见的双摄方案是广角摄像头(主)+长焦摄像头(副),主摄像头负责记录画面信息,副摄像头负责记录景深信息,算法通过各项参数识别主体,虚化背景,形成带有虚化效果的人像照片。

一向不随大流的谷歌自是不屑,人家要两个摄像头完成的事情,咱家一个就能搞定,不止搞得定,还要搞得好。少了一个副摄像头测景深,那这部分空缺的数据从何而来呢?

对,从算法中来。毕竟硬件不够,只好算法来凑。

在Pixel3之前,谷歌主要采用深度估计(Depth Estimation)的方式完成人像拍摄,这里面包含了语义分割(Semantic Segmentation)和立体算法(Stereo Algorithm)两个部分。在人像拍摄模式下,相机首先利用HDR+完成高质量照片拍摄,利用卷积神经网络(Convolutional Neural Network)识别图片中的主体和背景,并将两者进行分割,这里就是上面提到的语义分割。

(图自Google AI Blog)

接着,与双摄手机利用长焦镜头获取景深数据不同,Pixel利用双像素自动对焦技术获取景深信息并进行计算(即立体算法),形成深度图。最后将清晰的主体和深度图组合,完成照片虚化渲染。

双像素自动对焦(DPAF):将每个像素分为左右两部分,像素的右侧通过摄像头的左侧看世界,像素的左侧通过摄像头的右侧看世界,左右观测存在差值(即位差),相当于在同一个画面中用不同角度拍摄两次,两次比对得出位差,计算景深。

以上,可以简单的理解为用两种算法分别完成人像抠图+背景虚化。在背景虚化这一块,Pixel更像是在模拟专业相机的测算方法,但相较于专业相机而言难度更大。一方面,通过双像素自动对焦所产生的位差相当微弱,对手机摄像头而言更是极具挑战。另一方面,双像素自动对焦无法避免孔径问题(The Aperture Problem),水平或垂直方面的物体几乎无法判断出位差。因此,Pixel在人像拍摄上同样会存在由于无法识别为背景而无法虚化的情况。

为了改进,谷歌造了个5摄怪兽

说到这里,骚尼深知各位已经联想到了最近发布的三星A9s(全球首款后置四摄),又或是还在上市准备中的诺基亚9(据说是即将的全球首款后置五摄)。

(图自微博网友)

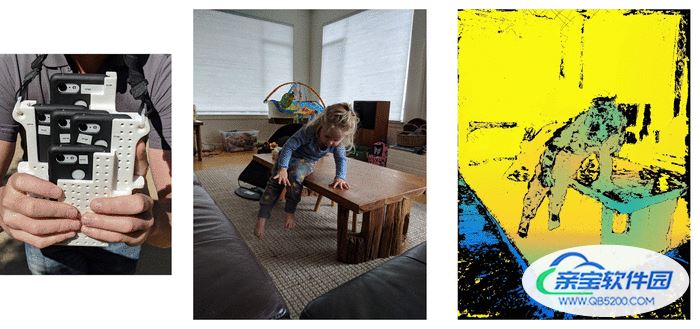

抱歉,让各位失望了,谷歌造的5摄怪兽其实长这样(看图掉粉系列)。

(图自Google AI Blog)

我没骗你,你也没看错,Pixel3五合一,真正的5摄怪兽,童叟无欺...

这台5摄怪兽被谷歌的AI工程师称为“Frankenphone”(我也是一台Phone)。除了装备5台Pixel3外,还搭载了一套基于WiFi的拍摄方案。通过Frankenphone,工程师能够同时捕获来自所有手机的照片(容差范围2ms),将所有的照片叠加在一起,便可以构成一个立体的视觉效果(左二)。

(图自Google AI Blog)

而获得这些照片非常适合用来训练前面提到的深度估计算法。原因非常简单:

1. 五个视点确保在多个方向上存在位差,因此没有孔径问题

2. 摄像头的布置确保照片中的点通常在至少一个其他照片中可见,没有对应关系的点更少

3. 摄像头之间的距离比单摄像头的PDAF产生的位差更大,深度估计会更准确

换句话来说,谷歌是承认多摄的优势的,但谷歌偏要通过从多摄上获取的数据来训练自家的人工智能算法,试图用一个摄像头来实现多摄的能力。如此做法,在某种程度上看其实是在炫技。背靠AI算法和大数据的Google相机,在得到充分得当的训练之后,成像效果的确有可能企及甚至超越多摄。从三代Pixel的相机能力发展来看,这一天正在走来。

从手机本身来看,手机内部空间本身就寸土寸金,能用单摄完成地事情,谁又愿意绞尽脑汁地往机身上堆摄像头?能用算法解决的问题,自然也无需硬件堆叠了。然而,在AI和大数据这两块能与谷歌比肩的有多少?在这之中的手机厂商又能有几个?在算法能力不足的情况下,这才有了双摄、三摄乃至五摄、六摄。换个角度来看,也就是“算法不够,硬件来凑”了。

最后就是来到对用户的发问:如果单摄能实现的事情,你还有必要买个多摄吗?

最后的最后,只生得一句:一顿操作猛如虎,Pixel誓死一挑五。

加载全部内容