Flink安装及实例教程

脑热 人气:1通过本教程我们将快速部署好flink在linux下的环境,并通过flink完成一个小demo的测试

一、准备阶段

flink压缩包下载(1.7.2): http://archive.apache.orghttps://img.qb5200.com/download-x/dist/flink/flink-1.7.2/flink-1.7.2-bin-hadoop26-scala_2.11.tgz

二、传入虚拟机并解压

压缩包下载完成后,通过虚拟机工具复制粘贴到虚拟机中(直接拖过去可能文件大小会出问题),虚拟机工具安装参考https:/https://img.qb5200.com/download-x/docs.vmware.com/cn/VMware-Fusion/11/com.vmware.fusion.using.doc/GUID-391BE4BF-89A9-4DC3-85E7-3D45F5124BC7.html

来到压缩包的存放位置

tar -xvf flink-1.7.2-bin-hadoop26-scala_2.11.tgz -C /home/tlj/flink

通过上面的命令进行解压,指令最后的路径是解压路径,这里我放在/home/tlj/flink下,请读者自行选择目录。

三、通过start-cluster.sh启动flink

解压完成后,进入flink的bin目录,通过start-cluster.sh启动flink:

./start-cluster.sh

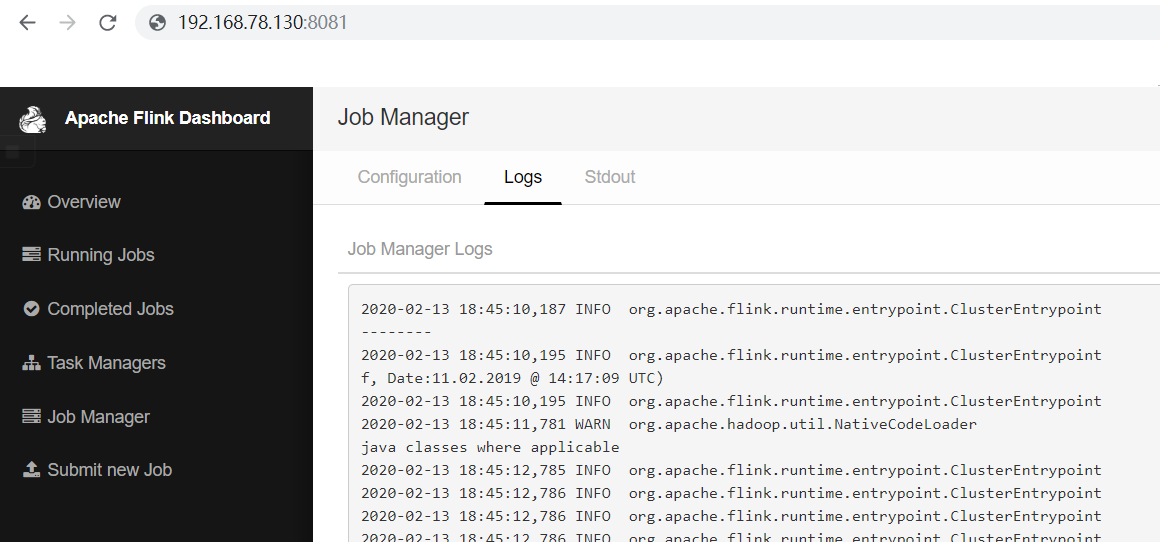

四、在主机上查看flink面板

启动完成后,在主机中打开浏览器,输入:

虚拟机的地址:8081

进入flink面板

五、测试WordCount案例

flink压缩包中自带了一个测试案例WordCount,实现单词出现数量的测试。

我们在新的终端中输入指令:

nc -l 8082

用来连接本地8082端口,此终端一会儿用来输入单词

接着我们再打开一个端口,并来到flink目录下

./bin/flink run examples/streaming/SocketWindowWordCount.jar --port 8082

回到上一个端口,随便输入一些单词,用空格隔开,通过回车发送。

接着我们打开flink下log目录中的flink-tlj-taskexecutor-0-bogon.out文件(注意文件名不一样,这里的tlj是我的用户名),会看到结果,对单词进行了统计。

加载全部内容